Nvidia anuncia nova arquitetura Hopper e serviços para acelerar “fábricas de IA”

Durante o GTC, empresa revelou novas plataformas que reforçam sua estratégia de oferecer "full stack" de tecnologia para IA

A Nvidia está em uma jornada para ser reconhecida não apenas como uma fabricante de chips, mas pela entrega de soluções “full stack” de tecnologia – abrangendo processadores, supercomputadores, software e serviços. Nesta terça-feira (22), durante a conferência Nvidia GTC, a companhia deu novos passos nessa estratégia, revelando novos hardwares e serviços voltados para processamento de inteligência artificial (IA).

Nas palavras de Jensen Huang, CEO da Nvidia, a organização ambiciona estar no “motor” das infraestruturas de IA do mundo — dando o suporte para verdadeiras “fábricas de IA“. “Os data centers de IA processam montanhas de dados contínuos para treinar e refinar modelos de IA”, disse Huang durante a abertura do evento, nesta terça-feira (22). “Dados brutos chegam, são refinados e a inteligência sai – as empresas estão fabricando inteligência e operando fábricas gigantes de IA.”

No centro dessa estratégia está a nova arquitetura Nvidia Hopper, batizada em homenagem à cientista da computação estadunidense Grace Hopper. A arquitetura é a sucessora da Nvidia Ampere, lançada há dois anos, e, segundo Huang, é o “maior salto geracional de todos os tempos” em desempenho.

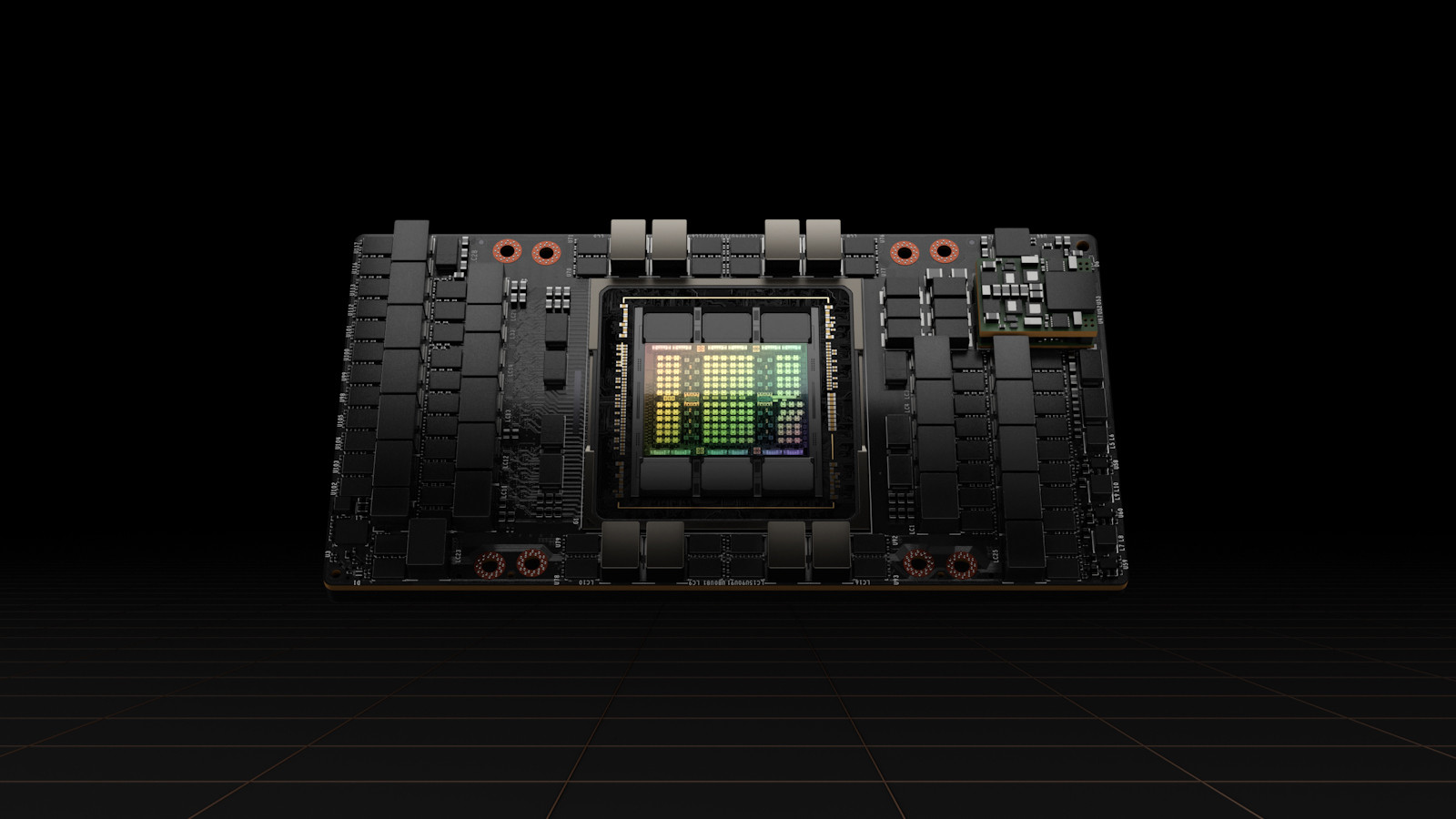

A GPU Nvidia H100 é a primeira anunciada pela companhia constituída na nova arquitetura. Com 80 bilhões de transistores, o H100 promete um novo padrão para aceleração de inteligência artificial e de computação de alta performance (HPC). Segunda a Nvidia, a H100 é a primeira GPU a oferecer suporte para PCI e de 5ª geração e possibilita largura de banda de memória de 3 TB/s.

A H100 também embarca recursos inéditos de computação confidencial, voltados para a proteção de modelos de IA e dados de clientes durante o processamento. De acordo com a empresa, a estrutura confidencial é focada em clientes de setores que dependem da privacidade, como saúde, serviços financeiros e em infraestruturas de cloud compartilhadas.

Com a H100, a Nvidia espera oferecer ganhos consideráveis em aplicações como processamento de conversação em tempo real, atingindo latência de menos de um segundo para esse tipo de solução, e para pesquisa genômica. Além da GPU, a empresa revelou o sistema DGX H100, que conta com oito GPUs e oferece 32 petaflops de desempenho de IA.

A Nvidia H100 pode ser implementada em todos os tipos de data center, incluindo on-premises, na nuvem, nuvem híbrida ou borda. A GPU tem lançamento previsto ainda para este ano.

Alibaba Cloud, AWS, Baidu AI Cloud, Google Cloud, Microsoft Azure, Oracle Cloud e Tencent Cloud planejam oferecer instâncias baseadas em H100. Servidores baseados na H100 são esperados pelas fabricantes Atos, Boxx Technologies, Cisco, Dell Technologies, Fujitsu, Gigabyte, H3C, Hewlett Packard Enterprise, Inspur, Lenovo, Nettrix e Supermicro.

Nvidia Eos

Para colocar o sistema DGX H100 em produção, a Nvidia revelou que construirá o supercomputador Eos. A estrutura DGX SuperPOD será desenhada com arquitetura de IA para impulsionar o trabalho dos pesquisadores da NVIDIA no avanço da ciência climática, biologia digital e o futuro da IA.

Espera-se que o Eos seja o sistema de IA mais rápido do mundo após iniciar suas operações, apresentando um total de 576 sistemas DGX H100 com 4608 GPUs DGX H100. O Eos fornecerá 18,4 exaflops de desempenho de computação de IA e processamento de IA quatro vezes mais rápido do que o supercomputador Fugaku, no Japão – atualmente o sistema mais rápido do mundo. Para computação científica tradicional, espera-se que o Eos forneça 275 petaflops de desempenho.

O supercomputador Eos deve entrar em operação ainda este ano.

Superchip de CPU Grace

Também no fronte de hardware, a Nvidia revelou o superchip de CPU Grace, primeira CPU de data center discreta baseada em ARM Neoverse. O superchip é projetado para aplicações de HPC, IA, análise de dados, computação científica e aplicações de computação de hiperescala com exigências de alto desempenho, largura de banda de memória, eficiência de energia e capacidade de configuração.

Os 144 núcleos e 1 TB/s de largura de banda de memória do superchip de CPU Grace prometem desempenho sem precedentes para aplicações de computação de alto desempenho baseados em CPU. As aplicações de HPC apresentam computação intensiva, exigindo os núcleos de maior desempenho, maior largura de banda de memória e a capacidade de memória certa por núcleo para acelerar os resultados.

A Nvidia está trabalhando com clientes em HPC, supercomputação, hiperescala e nuvem para o superchip de CPU Grace. Ele estará disponível no primeiro semestre de 2023.

AI Enterprise 2.0 e Riva 2.0

Na parte de software, a Nvidia revelou o AI Enterprise 2.0, pacote que contempla ferramentas de desenvolvimento e gestão de GPU e CPU. A plataforma é uma solução nativa de nuvem ponta a ponta e combina um conjunto de ferramentas e estruturas de IA e análise de dados, otimizados e certificados pela Nvidia.

Lançada no ano passado, a versão 1.0 do AI Enterprise atendia apenas VMWare e ambientes virtuais. A nova versão é expandida para bare metal, conta com outros orquestradores e provê suporte para todos os principais data centers e plataformas de nuvem.

Tecnologia de inteligência artificial com foco em processamento de linguagem natural e texto, o Nvidia Riva 2.0 também é outra das novidades. A solução é vista como uma “caixa de ferramentas” para criação de aplicativos personalizados de IA com fala em tempo real, com baixa latência e maior autenticidade. O Riva 2.0 conta com reconhecimento de fala em sete idiomas e suporte com especialistas da Nvidia.

Para clientes e desenvolvedores que desejam testar as plataformas da empresa, a tecnologia Nvidia Launch Pad será expandida em escala global. A plataforma permite a criação de provas de conceito para validar o stack de hardware e software da Nvidia dentro de uma estrutura da própria companhia. O programa está sendo apoiado pela Equinix e estará disponível também na América Latina.

Omniverse Cloud

A organização revelou ainda uma oferta inicial do Omniverse Cloud, conjunto de serviços em cloud que oferece a artistas, criadores, designers e desenvolvedores acesso instantâneo à plataforma Nvidia Omniverse para colaboração e simulação em design 3D na nuvem.

O Omniverse Cloud inclui diversos serviços, incluindo o Nucleus Cloud, ferramenta simples de compartilhamento com colaboração com um clique que permite que artistas acessem e editem grandes cenas 3D de qualquer lugar, sem precisar transferir conjuntos de dados enormes; o Omniverse Create, aplicação para artistas, criadores e designers técnicos criarem mundos 3D de forma interativa e em tempo real; e o View, uma aplicação para usuários não técnicos para visualização de cenas do Omniverse transmitindo recursos completos de simulação e renderização.